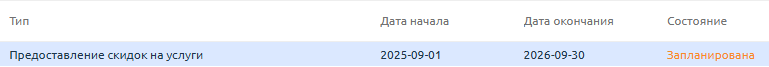

Прошлой скидкой при оплате на 1 год — на все тарифы selectel — никто не воспользовался не разу, почему-то. Заказать можно тут bill.yacolo.net/billmgr

Прошлой скидкой при оплате на 1 год — на все тарифы selectel — никто не воспользовался не разу, почему-то. Заказать можно тут bill.yacolo.net/billmgr

...

...

Наш ЦОД «Медведково», о котором мы уже рассказывали, в 2024 году стал кластером, так как рядом был построен еще один дата-центр — «Медведково-2». В этой статье мы покажем, как устроен новый ЦОД. Здание «Медведково-2» возвели за год, параллельно проводили интеграцию инженерных систем. К 2024 году ЦОД полностью подготовили для проведения аудита и сертификации. Дата-центр успешно прошел испытания Uptime Facility и получил сертификат Tier III.

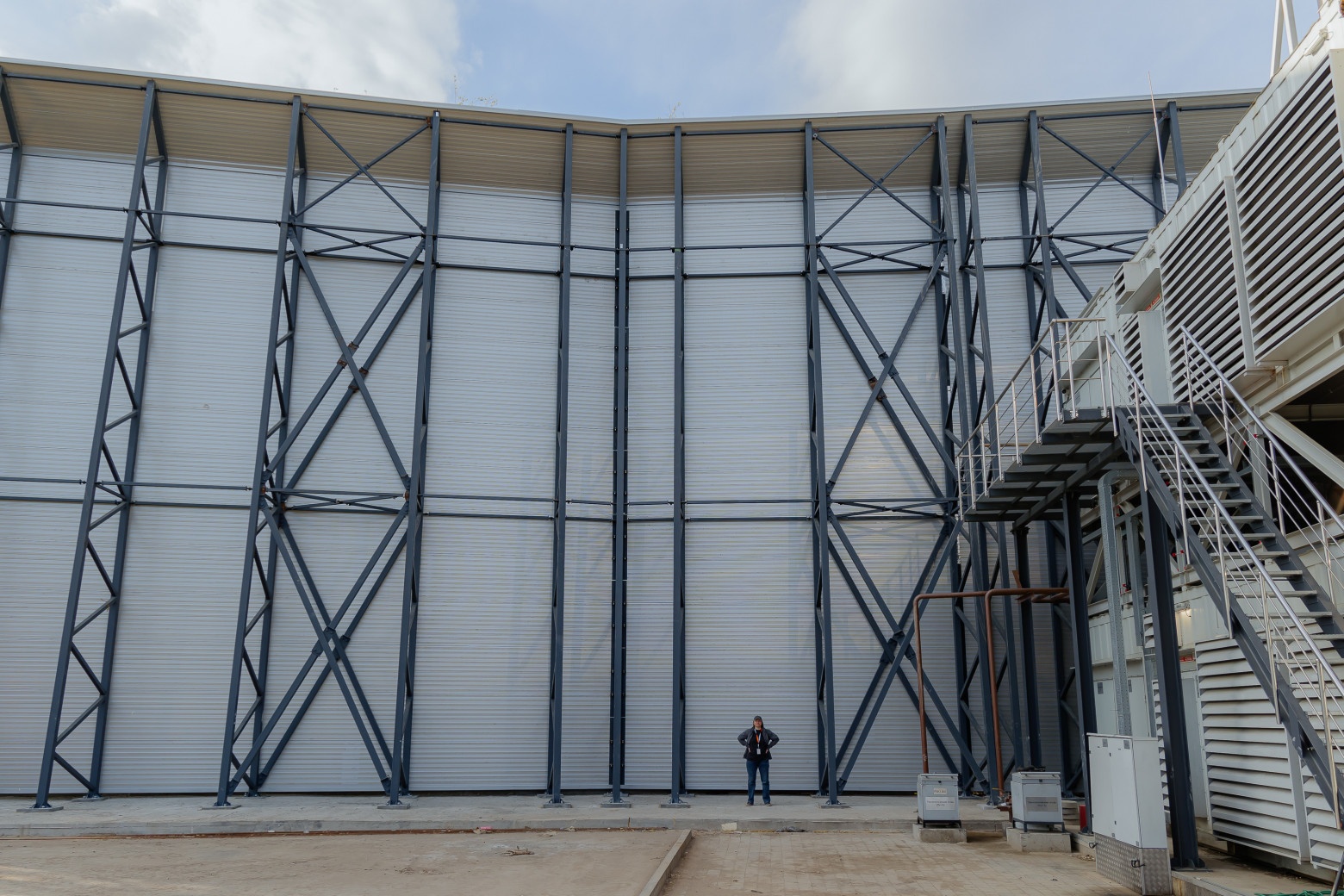

Наш ЦОД «Медведково», о котором мы уже рассказывали, в 2024 году стал кластером, так как рядом был построен еще один дата-центр — «Медведково-2». В этой статье мы покажем, как устроен новый ЦОД. Здание «Медведково-2» возвели за год, параллельно проводили интеграцию инженерных систем. К 2024 году ЦОД полностью подготовили для проведения аудита и сертификации. Дата-центр успешно прошел испытания Uptime Facility и получил сертификат Tier III.  Главное отличие «Медведково-2» — это вертикальная архитектура, так называемый стакан. За счет этого для нагрузки 36 МВт, как в «Медведково-1», потребовалась меньшая площадь застройки. Всего в «Медведково-2» семь этажей, высота здания — 40 метров. 16 машзалов рассчитаны на 4000 стоек — по 250 на каждый зал. Площадь технологических помещений составляет 22 000 кв. м. На двух нижних этажах расположены четыре независимых энергоцентра: РУ 10 кВ, ГРЩ, ТП, ИБП, на остальных — машинные залы, которые относятся к одному из четырех энергоцентров. На кровле размещены чиллеры.

Главное отличие «Медведково-2» — это вертикальная архитектура, так называемый стакан. За счет этого для нагрузки 36 МВт, как в «Медведково-1», потребовалась меньшая площадь застройки. Всего в «Медведково-2» семь этажей, высота здания — 40 метров. 16 машзалов рассчитаны на 4000 стоек — по 250 на каждый зал. Площадь технологических помещений составляет 22 000 кв. м. На двух нижних этажах расположены четыре независимых энергоцентра: РУ 10 кВ, ГРЩ, ТП, ИБП, на остальных — машинные залы, которые относятся к одному из четырех энергоцентров. На кровле размещены чиллеры.  В ЦОДе соблюдается единый стандарт обслуживания клиентов РТК-ЦОД: круглосуточный доступ в дата-центр, бесплатная парковка, комфортная зона для переговоров.

В ЦОДе соблюдается единый стандарт обслуживания клиентов РТК-ЦОД: круглосуточный доступ в дата-центр, бесплатная парковка, комфортная зона для переговоров.

Физическая безопасность Работает круглосуточная охрана. Во всех помещениях и на территории ЦОДа ведется видеонаблюдение. Все соответствует национальному стандарту Российской Федерации «Системы охраны и безопасности» ГОСТ Р 52551-2016 и стандартам ISO 27001, PCI DSS.

Физическая безопасность Работает круглосуточная охрана. Во всех помещениях и на территории ЦОДа ведется видеонаблюдение. Все соответствует национальному стандарту Российской Федерации «Системы охраны и безопасности» ГОСТ Р 52551-2016 и стандартам ISO 27001, PCI DSS.

Машинные залы Машинные залы защищены от пыли, колебаний уровня влажности и температуры. Внутри поддерживается оптимальный микроклимат, есть система автоматического пожаротушения, ведется круглосуточный мониторинг инженерного оборудования. Топология размещения серверных стоек реализована по принципу холодных и горячих коридоров. Расстояние между рядами стоек в холодном коридоре составляет 1200 мм. Подача охлажденного воздуха к серверным стойкам идет через перфорированную плитку фальшпола в холодных коридорах. Высота фальшпола — 1350 мм. Пропускная способность перфорированных плиток составляет не менее 38% от общей площади плитки. В холодных коридорах поддерживается температура 23±3 °С и влажность 30–70 %. Увлажнители размещены внутри корпусов кондиционеров. Каждый модуль рассчитан на отвод 6 МВт тепловой нагрузки от ИТ-оборудования.

Машинные залы Машинные залы защищены от пыли, колебаний уровня влажности и температуры. Внутри поддерживается оптимальный микроклимат, есть система автоматического пожаротушения, ведется круглосуточный мониторинг инженерного оборудования. Топология размещения серверных стоек реализована по принципу холодных и горячих коридоров. Расстояние между рядами стоек в холодном коридоре составляет 1200 мм. Подача охлажденного воздуха к серверным стойкам идет через перфорированную плитку фальшпола в холодных коридорах. Высота фальшпола — 1350 мм. Пропускная способность перфорированных плиток составляет не менее 38% от общей площади плитки. В холодных коридорах поддерживается температура 23±3 °С и влажность 30–70 %. Увлажнители размещены внутри корпусов кондиционеров. Каждый модуль рассчитан на отвод 6 МВт тепловой нагрузки от ИТ-оборудования.

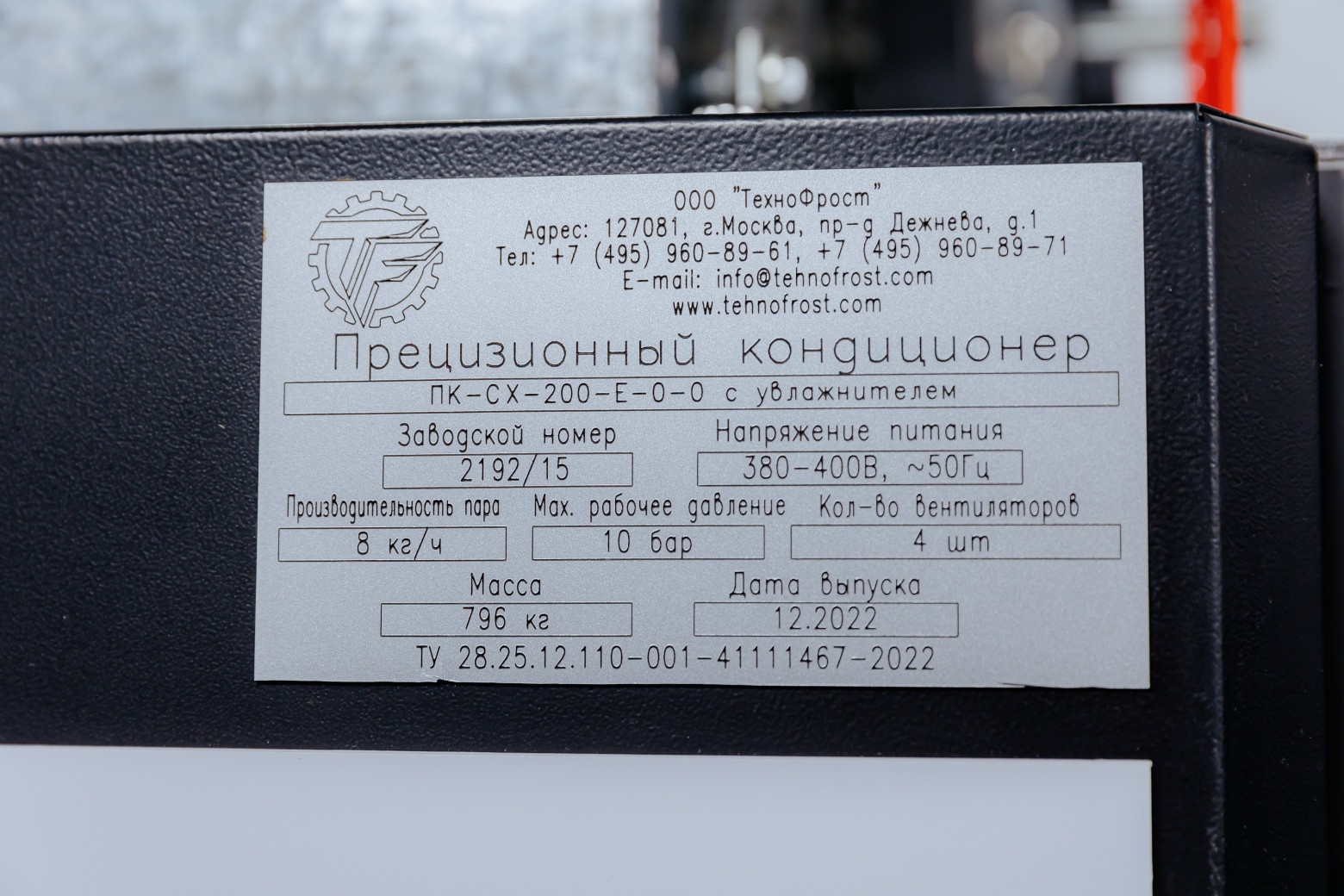

По вопросам установки и эксплуатации клиентского оборудования круглосуточно доступны филды и дежурные инженеры (услуга Smart Hands). Климат В системе холодоснабжения «Медведково-2» работает 170 прецизионных кондиционеров внутри ЦОДа и 74 чиллера на крыше. Они обслуживают 16 машинных залов и помещения MMR, MDA, ИБП, КСБ.

По вопросам установки и эксплуатации клиентского оборудования круглосуточно доступны филды и дежурные инженеры (услуга Smart Hands). Климат В системе холодоснабжения «Медведково-2» работает 170 прецизионных кондиционеров внутри ЦОДа и 74 чиллера на крыше. Они обслуживают 16 машинных залов и помещения MMR, MDA, ИБП, КСБ.  Вентиляционные коридоры с кондиционерами отделены от машинного зала с клиентским оборудованием. Это позволяет службе эксплуатации проводить плановые работы без посещения основного пространства машинного зала.

Вентиляционные коридоры с кондиционерами отделены от машинного зала с клиентским оборудованием. Это позволяет службе эксплуатации проводить плановые работы без посещения основного пространства машинного зала.  Мощность каждого кондиционера — 230 кВт. Оборудование оснащено датчиками протечки воды. Каждый кондиционер на теплообменнике имеет фильтр для обработки проходящего через него воздуха (класс очистки — М5). Оптимальный уровень влажности по SLA обеспечивают увлажнители и осушители. Схема резервирования системы холодоснабжения N+1.

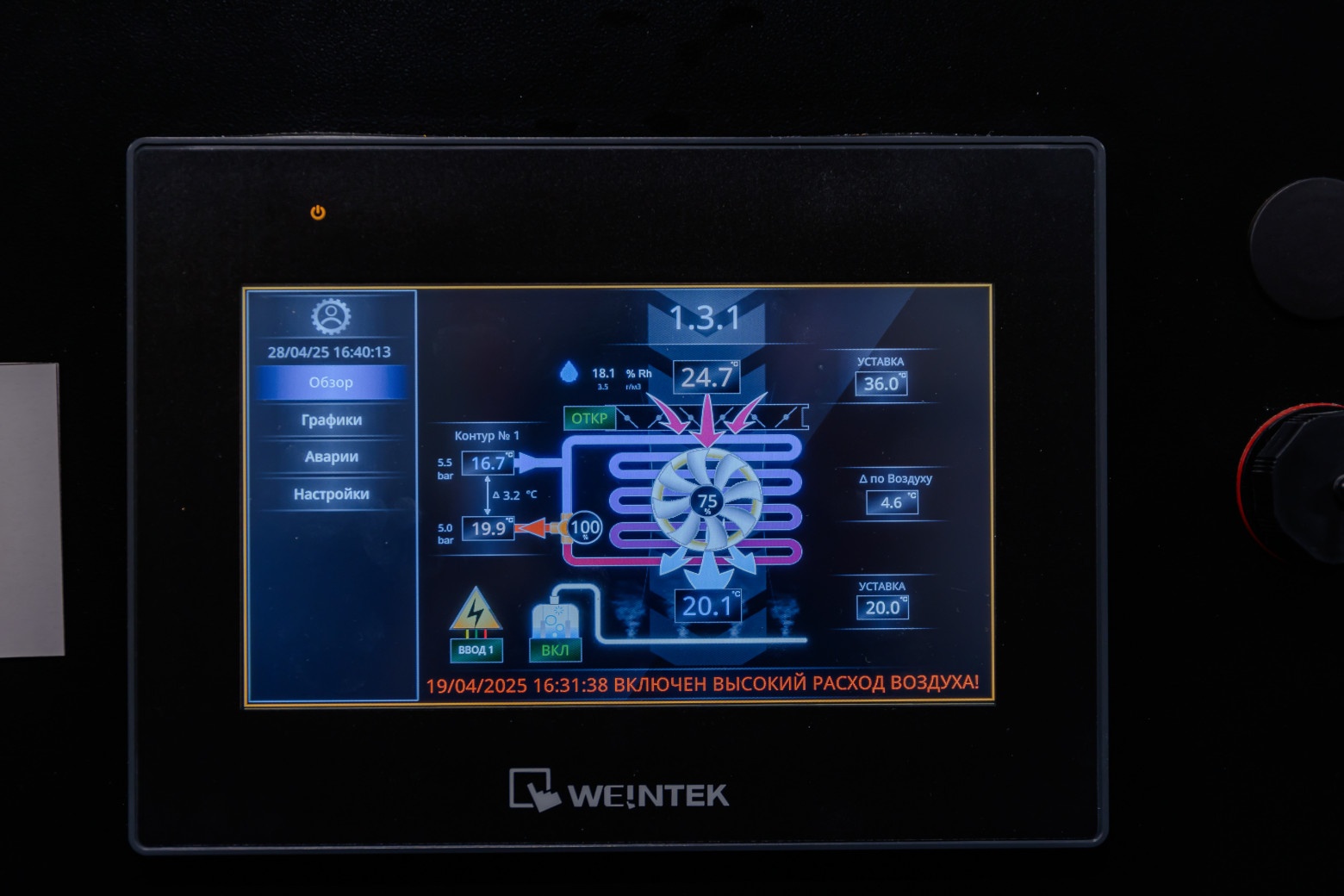

Мощность каждого кондиционера — 230 кВт. Оборудование оснащено датчиками протечки воды. Каждый кондиционер на теплообменнике имеет фильтр для обработки проходящего через него воздуха (класс очистки — М5). Оптимальный уровень влажности по SLA обеспечивают увлажнители и осушители. Схема резервирования системы холодоснабжения N+1.  При номинальной проектной нагрузке одновременно работают все восемь кондиционеров в машзале, включая резервные. Если один кондиционер выходит из строя, оставшиеся семь автоматически распределяют тепловую нагрузку между собой с изменением уставки на повышенный расход воздуха. Неисправный кондиционер автоматически выводится из работы, чтобы не произошла подача горячего воздуха в машинный зал. На крыше находятся аккумулирующие баки емкостью 3000 литров каждый. В них — охлажденный этиленгликоль на случай отказа электропитания компрессоров в чиллерах. Если пропадает электропитание в общегородской сети, во время перехода на дизель-генераторные установки (ДГУ) часть компрессоров в чиллерах перезапускается. Для выхода на рабочую мощность чиллерам нужно до 3 минут. Баки обеспечат до 4 минут поддержания температуры гликоля. В схеме электроснабжения насосных групп чиллеров присутствует ИБП, при переходах на резервный источник питания насосы не перезапускаются. Мощность каждого чиллера — 470 кВт. Чиллеры имеют один холодильный контур с винтовыми и безмасляными центробежными компрессорами. Предусмотрена плавная регулировка холодопроизводительности. Уровень резервирования холодильных машин N+1: из 16 чиллеров два — резервные с учетом топологии ЦОДа. 14 работающих чиллеров производят 100% холода для четырех машинных залов каждого энергоцентра. При температуре воздуха снаружи ниже +10 °С чиллеры переходят в режим фрикулинга, что дает большую энергоэффективность ЦОДа. Если температура окружающей среды выше +10 °С, чиллеры запускаются в компрессорном режиме.

При номинальной проектной нагрузке одновременно работают все восемь кондиционеров в машзале, включая резервные. Если один кондиционер выходит из строя, оставшиеся семь автоматически распределяют тепловую нагрузку между собой с изменением уставки на повышенный расход воздуха. Неисправный кондиционер автоматически выводится из работы, чтобы не произошла подача горячего воздуха в машинный зал. На крыше находятся аккумулирующие баки емкостью 3000 литров каждый. В них — охлажденный этиленгликоль на случай отказа электропитания компрессоров в чиллерах. Если пропадает электропитание в общегородской сети, во время перехода на дизель-генераторные установки (ДГУ) часть компрессоров в чиллерах перезапускается. Для выхода на рабочую мощность чиллерам нужно до 3 минут. Баки обеспечат до 4 минут поддержания температуры гликоля. В схеме электроснабжения насосных групп чиллеров присутствует ИБП, при переходах на резервный источник питания насосы не перезапускаются. Мощность каждого чиллера — 470 кВт. Чиллеры имеют один холодильный контур с винтовыми и безмасляными центробежными компрессорами. Предусмотрена плавная регулировка холодопроизводительности. Уровень резервирования холодильных машин N+1: из 16 чиллеров два — резервные с учетом топологии ЦОДа. 14 работающих чиллеров производят 100% холода для четырех машинных залов каждого энергоцентра. При температуре воздуха снаружи ниже +10 °С чиллеры переходят в режим фрикулинга, что дает большую энергоэффективность ЦОДа. Если температура окружающей среды выше +10 °С, чиллеры запускаются в компрессорном режиме.

Система холодоснабжения оборудована баками компенсации давления. В случае увеличения давления гликоля в системе холодоснабжения это позволяет стабилизировать давление в контуре на нужном уровне.

Система холодоснабжения оборудована баками компенсации давления. В случае увеличения давления гликоля в системе холодоснабжения это позволяет стабилизировать давление в контуре на нужном уровне.  Станция подпитки гликолем постоянно функционирует в дежурном режиме. Если возникнет нехватка гликоля в результате протечки или потери давления, то дежурный персонал оперативно подпитает систему. Станция оснащена подогревом. В зимний период при выводе холодильной машины или чиллера в сервис мы включаем насос, и гликоль циркулирует через станцию подогрева гликолевого контура, чтобы не остывать ниже рекомендуемой производителем температуры эксплуатации (–28 °С). Энергетика ЦОД запитан по высокому напряжению от электросетей: по 10 кВт от городского питания и от резервного источника питания КДГУ. К электропитанию потребителей ИТ-нагрузки по напряжению 0,4 кВт приходит 4 луча электропитания по топологической схеме резервирования 4/3 N. Магистральный шинопровод электропитания организован в вертикальной проекции и горизонтально расходится по этажам в машзалы. В составе ЦОДа предусмотрены четыре независимых энергоцентра: РУ 10 кВ, ГРЩ, ТП, ИБП, РП ДГУ, ШП, ЩР. На каждый энергоцентр приходится 6 МВт ИТ-нагрузки и 3 МВт — механической для инженерных систем, на каждую стойку — от 5 до 15 кВт.

Станция подпитки гликолем постоянно функционирует в дежурном режиме. Если возникнет нехватка гликоля в результате протечки или потери давления, то дежурный персонал оперативно подпитает систему. Станция оснащена подогревом. В зимний период при выводе холодильной машины или чиллера в сервис мы включаем насос, и гликоль циркулирует через станцию подогрева гликолевого контура, чтобы не остывать ниже рекомендуемой производителем температуры эксплуатации (–28 °С). Энергетика ЦОД запитан по высокому напряжению от электросетей: по 10 кВт от городского питания и от резервного источника питания КДГУ. К электропитанию потребителей ИТ-нагрузки по напряжению 0,4 кВт приходит 4 луча электропитания по топологической схеме резервирования 4/3 N. Магистральный шинопровод электропитания организован в вертикальной проекции и горизонтально расходится по этажам в машзалы. В составе ЦОДа предусмотрены четыре независимых энергоцентра: РУ 10 кВ, ГРЩ, ТП, ИБП, РП ДГУ, ШП, ЩР. На каждый энергоцентр приходится 6 МВт ИТ-нагрузки и 3 МВт — механической для инженерных систем, на каждую стойку — от 5 до 15 кВт.

К каждому энергоцентру подведены независимыми маршрутами два отдельных ввода электропитания. Действует система гарантированного и бесперебойного энергоснабжения на базе ДГУ и ИБП, в экстренной ситуации для автоматического переключения между вводами и ДГУ сработает автоматический ввод резерва АВР. Заземление всех конструкций и оборудования организовано по единому контуру. В отличие от «Медведково-1», где ИБП со свинцовыми аккумуляторами, в новом дата-центре используются литий-ионные аккумуляторы. При той же мощности у них меньший объем, сами устройства более экономны и долговечны. В батарейные блоки встроены модули, которые обеспечат тушение при повышении температуры выше 80 °С. В батарейных модулях используется негорючий литий, что подтвердили испытания, которые были проведены совместно с нашими инженерами на заводе АКБ VISION в Китае. При переходе с высокой стороны на низкую (400 вольт) в энергоцентрах используются сухие трансформаторы. За счет отсутствие масла эксплуатация удобнее и экологичнее, выше пожарная безопасность. Система гарантированного энергоснабжения Рядом с ЦОДом установлено 24 контейнерных дизель-генераторных установки (КДГУ) суммарной мощностью 48 МВт. Объем топливохранилища — 192 тонны, по 8 тонн на каждую КДГУ. Энергопроизводительность каждой машины — 2 МВт. Запаса топлива хватает на 17 часов автономной работы дата-центра. Топливо доставляют два независимых поставщика. Гарантированный срок поставки топлива для дозаправки ДГУ — четыре часа. Двухэтажная площадка КДГУ двухэтажная оборудована дополнительными кожухами шумопоглощения и со стороны спальных районов города закрыта 15-метровой шумопоглощающей стеной.

К каждому энергоцентру подведены независимыми маршрутами два отдельных ввода электропитания. Действует система гарантированного и бесперебойного энергоснабжения на базе ДГУ и ИБП, в экстренной ситуации для автоматического переключения между вводами и ДГУ сработает автоматический ввод резерва АВР. Заземление всех конструкций и оборудования организовано по единому контуру. В отличие от «Медведково-1», где ИБП со свинцовыми аккумуляторами, в новом дата-центре используются литий-ионные аккумуляторы. При той же мощности у них меньший объем, сами устройства более экономны и долговечны. В батарейные блоки встроены модули, которые обеспечат тушение при повышении температуры выше 80 °С. В батарейных модулях используется негорючий литий, что подтвердили испытания, которые были проведены совместно с нашими инженерами на заводе АКБ VISION в Китае. При переходе с высокой стороны на низкую (400 вольт) в энергоцентрах используются сухие трансформаторы. За счет отсутствие масла эксплуатация удобнее и экологичнее, выше пожарная безопасность. Система гарантированного энергоснабжения Рядом с ЦОДом установлено 24 контейнерных дизель-генераторных установки (КДГУ) суммарной мощностью 48 МВт. Объем топливохранилища — 192 тонны, по 8 тонн на каждую КДГУ. Энергопроизводительность каждой машины — 2 МВт. Запаса топлива хватает на 17 часов автономной работы дата-центра. Топливо доставляют два независимых поставщика. Гарантированный срок поставки топлива для дозаправки ДГУ — четыре часа. Двухэтажная площадка КДГУ двухэтажная оборудована дополнительными кожухами шумопоглощения и со стороны спальных районов города закрыта 15-метровой шумопоглощающей стеной.

Пожарная безопасность В ЦОДе ведется круглосуточный мониторинг, работают система раннего обнаружения продуктов горения (СРОП) и система газового пожаротушения на основе газа хладон-227еа. Общий объем станции газового пожаротушения — 48 тонн. Схема резервирования системы — 2N. Телеком В ЦОД выстроена отказоустойчивая сетевая инфраструктура на основе двух независимых волоконно-оптических сетевых вводов. Есть Meet-Me-Roomи восемь отдельных помещений пассивного оптического кросса. Поддерживается сетевой нейтралитет, можно подключать каналы связи любого оператора или использовать ВОЛС РТК-ЦОД. Дата-центр «Медведково-2» обеспечивает стабильную работу тысяч информационных систем. Вместе с «Медведково-1» ЦОД признан «Кластером ЦОД года» по версии премии «ЦОДы.РФ» 2025 года. Жюри высоко оценило масштаб, соответствие высоким стандартам отказоустойчивости, инновационную архитектуру и надежность кластера.

Пожарная безопасность В ЦОДе ведется круглосуточный мониторинг, работают система раннего обнаружения продуктов горения (СРОП) и система газового пожаротушения на основе газа хладон-227еа. Общий объем станции газового пожаротушения — 48 тонн. Схема резервирования системы — 2N. Телеком В ЦОД выстроена отказоустойчивая сетевая инфраструктура на основе двух независимых волоконно-оптических сетевых вводов. Есть Meet-Me-Roomи восемь отдельных помещений пассивного оптического кросса. Поддерживается сетевой нейтралитет, можно подключать каналы связи любого оператора или использовать ВОЛС РТК-ЦОД. Дата-центр «Медведково-2» обеспечивает стабильную работу тысяч информационных систем. Вместе с «Медведково-1» ЦОД признан «Кластером ЦОД года» по версии премии «ЦОДы.РФ» 2025 года. Жюри высоко оценило масштаб, соответствие высоким стандартам отказоустойчивости, инновационную архитектуру и надежность кластера.  cloud.rt.ru/registration cloud.rt.ru/showcase/tariffs...

cloud.rt.ru/registration cloud.rt.ru/showcase/tariffs...

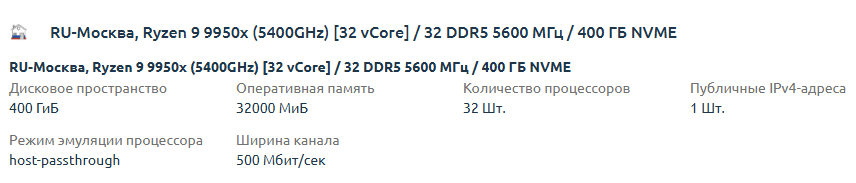

Мы уже писали о том, как придумали использовать десктопные компоненты в серверных стойках. Сегодня рассказываем об очередном вызове — компоновке высокпроизводительного железа с водяным охлаждением. Привет! На связи Виталий, дежурный системный инженер дата-центра в Selectel. Продолжаем тему, поднятую в наших предыдущих публикациях, где мы говорили об уплотнении серверов линейки ChipCore и усмирении Ryzen® в мини‑корпусе. Сегодня углубимся в специфику размещения по‑настоящему мощного оборудования. Напомню, нашей главной целью было эффективно использовать стандартные 19‑дюймовые серверные стойки для размещения систем, собранных из высокопроизводительных десктопных компонентов. Очевидно, что для решения этой задачи, разработки собственного корпуса не избежать. В отличие от прошлых проектов, появилась новая особенность — железо экстремальной производительности с потребляемой мощностью, значительно превышающей стандартные показатели TDP в 180 Вт. Конфигурации на базе процессоров Intel Core® i9-13900K или AMD Ryzen® 9 7950X с 128 ГБ памяти DDR5 и быстрыми NVMe-накопителями по 2 ТБ — настоящие «печки». Было изначально понятно, что без жидкостной системы охлаждения (СЖО) в этот раз не обойтись. При создании серверов подобного уровня производительности мы сперва взяли стандартный корпус форм-фактора Tower АТХ. Он был оснащен СЖО — чаще всего мы брали модели MSI P240 и С240, которые хорошо справлялась с отводом тепла. Возникла существенная проблема — нерациональное использование пространства внутри стандартных серверных шкафов. В 19-дюймовую стойку удалось установить максимум восемь–девять таких устройств. Этот факт стал значимым ограничением, ведь уровень заполнения стойки не превышал отметку в 18−20%. Такой подход вынудил нас искать пути улучшения компоновки.

Мы уже писали о том, как придумали использовать десктопные компоненты в серверных стойках. Сегодня рассказываем об очередном вызове — компоновке высокпроизводительного железа с водяным охлаждением. Привет! На связи Виталий, дежурный системный инженер дата-центра в Selectel. Продолжаем тему, поднятую в наших предыдущих публикациях, где мы говорили об уплотнении серверов линейки ChipCore и усмирении Ryzen® в мини‑корпусе. Сегодня углубимся в специфику размещения по‑настоящему мощного оборудования. Напомню, нашей главной целью было эффективно использовать стандартные 19‑дюймовые серверные стойки для размещения систем, собранных из высокопроизводительных десктопных компонентов. Очевидно, что для решения этой задачи, разработки собственного корпуса не избежать. В отличие от прошлых проектов, появилась новая особенность — железо экстремальной производительности с потребляемой мощностью, значительно превышающей стандартные показатели TDP в 180 Вт. Конфигурации на базе процессоров Intel Core® i9-13900K или AMD Ryzen® 9 7950X с 128 ГБ памяти DDR5 и быстрыми NVMe-накопителями по 2 ТБ — настоящие «печки». Было изначально понятно, что без жидкостной системы охлаждения (СЖО) в этот раз не обойтись. При создании серверов подобного уровня производительности мы сперва взяли стандартный корпус форм-фактора Tower АТХ. Он был оснащен СЖО — чаще всего мы брали модели MSI P240 и С240, которые хорошо справлялась с отводом тепла. Возникла существенная проблема — нерациональное использование пространства внутри стандартных серверных шкафов. В 19-дюймовую стойку удалось установить максимум восемь–девять таких устройств. Этот факт стал значимым ограничением, ведь уровень заполнения стойки не превышал отметку в 18−20%. Такой подход вынудил нас искать пути улучшения компоновки.  Рассмотрим возможные способы увеличения плотности установки серверов аналогичного уровня производительности и энергозатрат. Важно: необходимо сохранить при этом высокую эффективность теплоотвода и надежность функционирования. Slim Tower Первоначальная модернизация предполагала создание специального шасси и монтажной панели. Корпус изготавливался методом лазерной резки и гибки из оцинкованного стального листа марки SGCC толщиной 1,2 мм с последующей порошковой окраской.

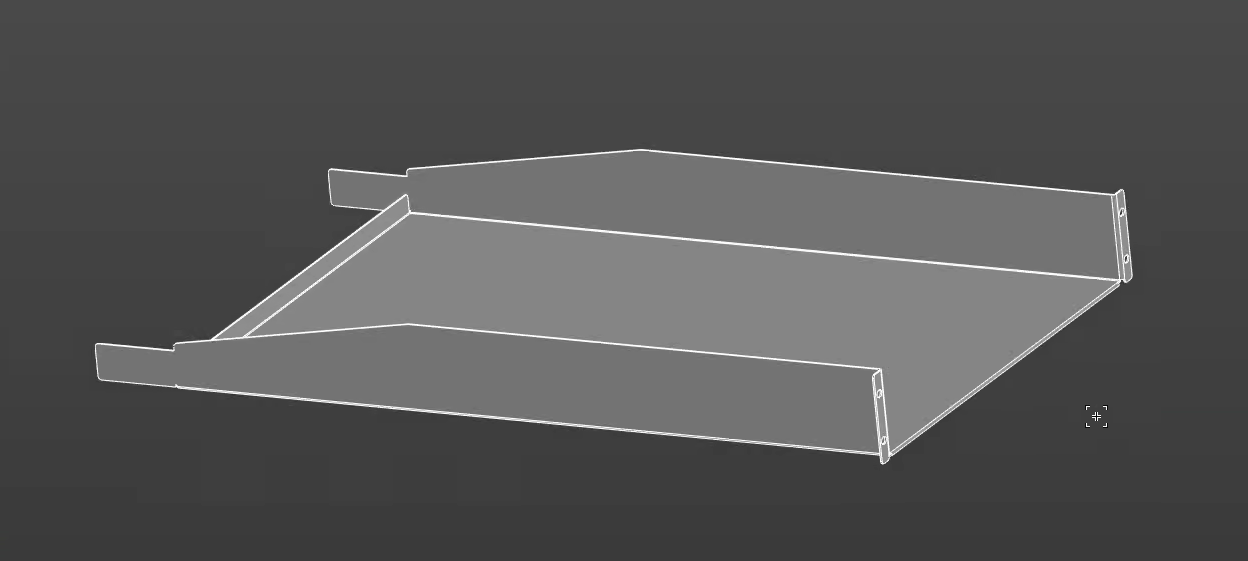

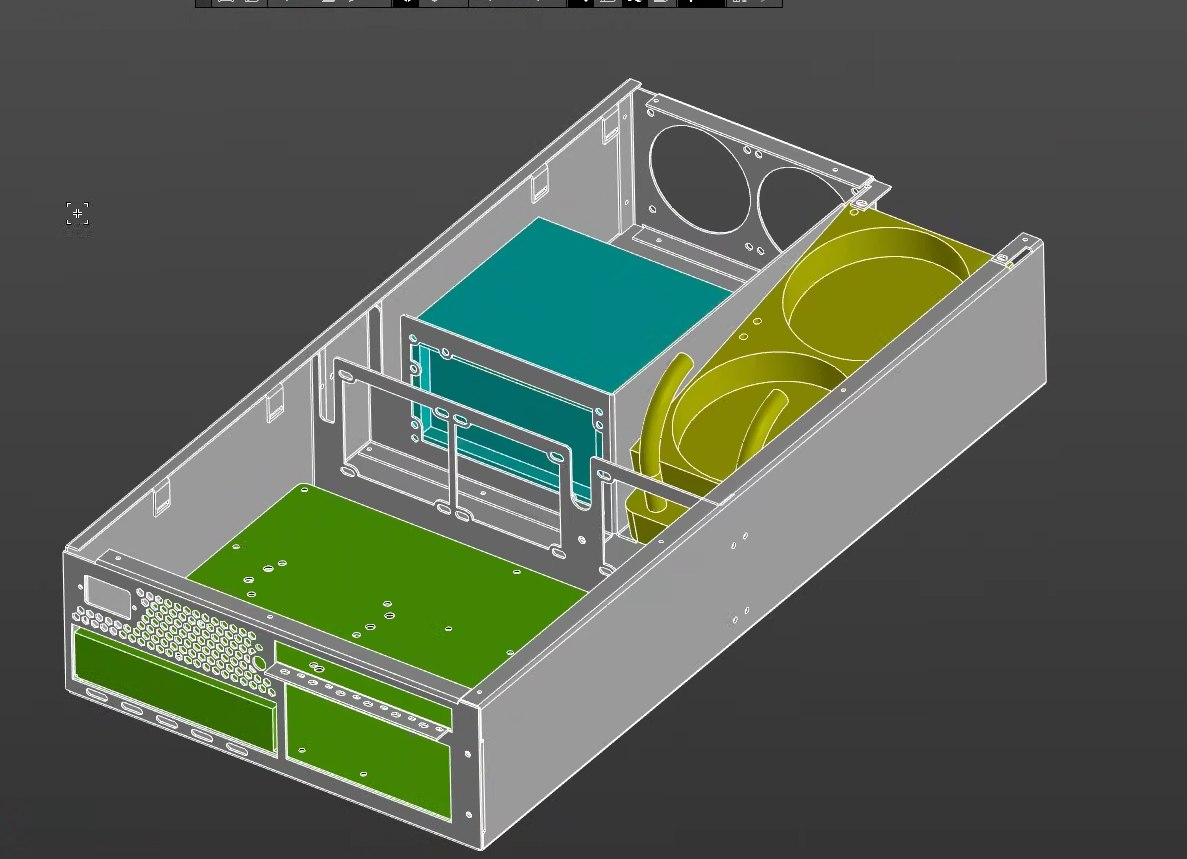

Рассмотрим возможные способы увеличения плотности установки серверов аналогичного уровня производительности и энергозатрат. Важно: необходимо сохранить при этом высокую эффективность теплоотвода и надежность функционирования. Slim Tower Первоначальная модернизация предполагала создание специального шасси и монтажной панели. Корпус изготавливался методом лазерной резки и гибки из оцинкованного стального листа марки SGCC толщиной 1,2 мм с последующей порошковой окраской.  При разработке мы в значительной степени опирались на предыдущий опыт создания корпусов, о котором уже рассказывали в других статьях.

При разработке мы в значительной степени опирались на предыдущий опыт создания корпусов, о котором уже рассказывали в других статьях.  Высота получилась два юнита (2U). Поскольку корпуса расположились вертикально, их ряд занял 7,5U. Хотя общий объем увеличился по сравнению со стандартным АТХ с горизонтальным размером около 5U, такая компоновка вместила четыре мощнейших вычислительных узла на одной полке. Вертикальный размер U = 1,75″ ≈ 44,45 мм. Соответственно: 2U ≈ 9 см, 5U ≈ 22 см, 7,5U ≈ 33 см. Для отвода тепла мы воспользовались системой жидкостного охлаждения с двухсекционным радиатором. При первичной отладке прототипов степень охлаждения поверхностей измеряли простым пирометром. Ни в одной точке он не зафиксировал температуру выше 85 5°C.

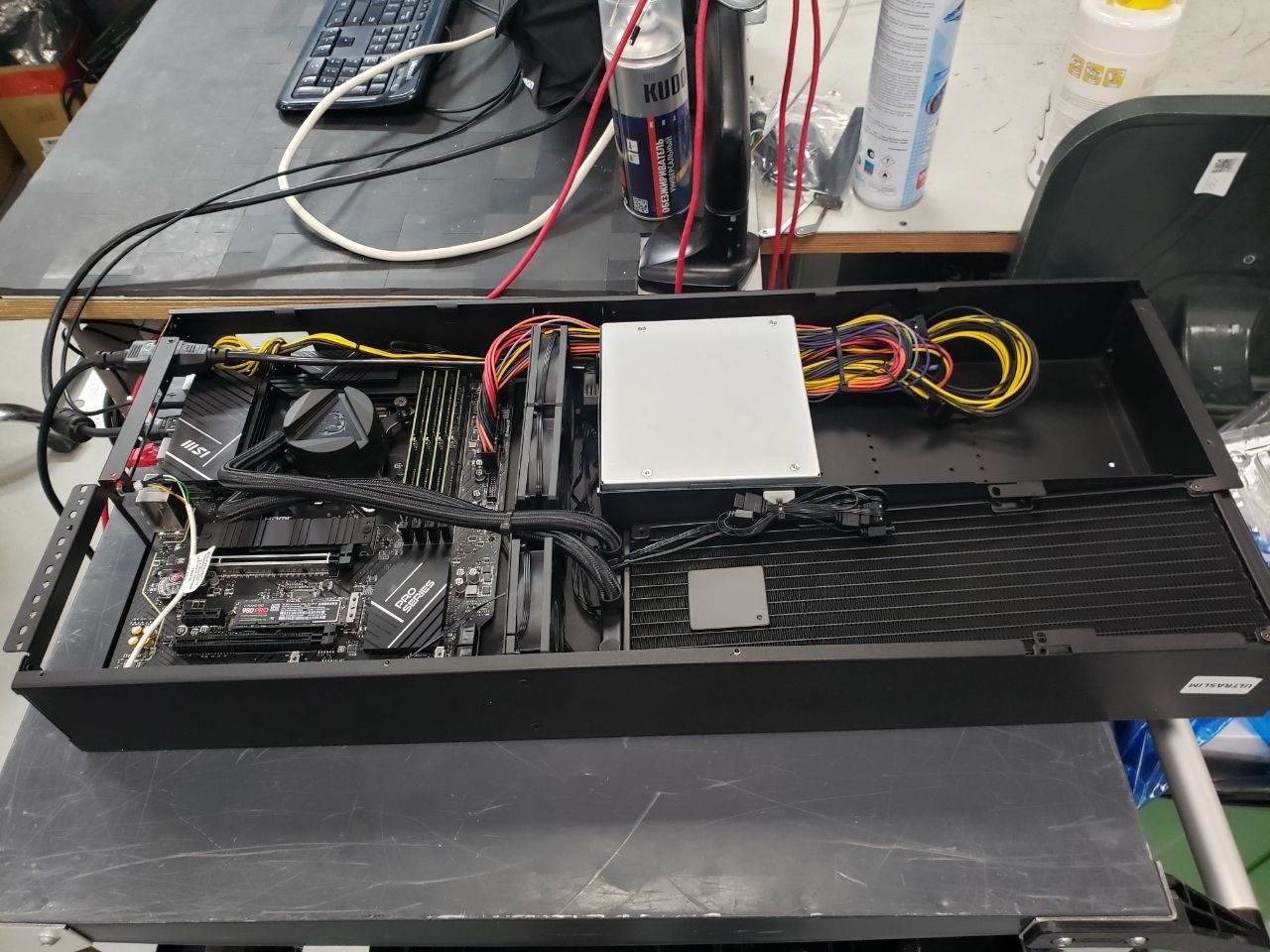

Высота получилась два юнита (2U). Поскольку корпуса расположились вертикально, их ряд занял 7,5U. Хотя общий объем увеличился по сравнению со стандартным АТХ с горизонтальным размером около 5U, такая компоновка вместила четыре мощнейших вычислительных узла на одной полке. Вертикальный размер U = 1,75″ ≈ 44,45 мм. Соответственно: 2U ≈ 9 см, 5U ≈ 22 см, 7,5U ≈ 33 см. Для отвода тепла мы воспользовались системой жидкостного охлаждения с двухсекционным радиатором. При первичной отладке прототипов степень охлаждения поверхностей измеряли простым пирометром. Ни в одной точке он не зафиксировал температуру выше 85 5°C.  После финальной доработки наш смежный отдел тестирования оборудования провел полную серию нагрузочных испытаний. Они применяют специализированное программное обеспечение, которое доводит все компоненты до предельных режимов. Детали своей работы ребята не раскрывают, но финальный отчет подтвердил — система охлаждения полностью справляется с задачей, имеет стабильные показатели и не допускает перегрева никаких компонентов. Блок питания размещался непосредственно внутри платформы. Такое решение дает дополнительное охлаждение и самого блока, и радиаторов СЖО воздухом из холодных коридоров серверной комнаты. Для понимания среды, в которой работают серверы, отвлечемся на небольшое техническое описание горячих и холодных коридоров. Стойки стоят плотными рядами. Их передние панели смотрят друг на друга и образуют «холодный коридор». Задние части также обращены друг к другу и формируют «горячий коридор». Через перфорированные плиты фальшпола охлажденный воздух подается в холодный коридор. Затем он забирается вентиляторами систем охлаждения серверов и проходит через компоненты оборудования. Наконец, отобравший тепло воздух выбрасывается в изолированный горячий коридор. Оттуда поток возвращается к прецизионным кондиционерам для охлаждения и повторения цикла. Система питания построена на связке двух компонентов: DELTA STS30002SR — автоматический ввод резерва в стойках;Tesla Power TP-STD-C20A04В — блоки распределения питания.Со стороны блоки выглядят как ряд обычных розеток. При этом они бывают как управляемые, так и неуправляемые. На всех стойках линейки ChipCоге мы используем только первый тип, чтобы иметь возможность перезагрузить сервер при необходимости. Продуманная конструкция платформ позволила использовать существующие кабели питания стандартной длины. Нам не пришлось усложнять кабель-менеджмент, изготавливать или заказывать что-то особенное — это еще один плюс к эффективности решения.

После финальной доработки наш смежный отдел тестирования оборудования провел полную серию нагрузочных испытаний. Они применяют специализированное программное обеспечение, которое доводит все компоненты до предельных режимов. Детали своей работы ребята не раскрывают, но финальный отчет подтвердил — система охлаждения полностью справляется с задачей, имеет стабильные показатели и не допускает перегрева никаких компонентов. Блок питания размещался непосредственно внутри платформы. Такое решение дает дополнительное охлаждение и самого блока, и радиаторов СЖО воздухом из холодных коридоров серверной комнаты. Для понимания среды, в которой работают серверы, отвлечемся на небольшое техническое описание горячих и холодных коридоров. Стойки стоят плотными рядами. Их передние панели смотрят друг на друга и образуют «холодный коридор». Задние части также обращены друг к другу и формируют «горячий коридор». Через перфорированные плиты фальшпола охлажденный воздух подается в холодный коридор. Затем он забирается вентиляторами систем охлаждения серверов и проходит через компоненты оборудования. Наконец, отобравший тепло воздух выбрасывается в изолированный горячий коридор. Оттуда поток возвращается к прецизионным кондиционерам для охлаждения и повторения цикла. Система питания построена на связке двух компонентов: DELTA STS30002SR — автоматический ввод резерва в стойках;Tesla Power TP-STD-C20A04В — блоки распределения питания.Со стороны блоки выглядят как ряд обычных розеток. При этом они бывают как управляемые, так и неуправляемые. На всех стойках линейки ChipCоге мы используем только первый тип, чтобы иметь возможность перезагрузить сервер при необходимости. Продуманная конструкция платформ позволила использовать существующие кабели питания стандартной длины. Нам не пришлось усложнять кабель-менеджмент, изготавливать или заказывать что-то особенное — это еще один плюс к эффективности решения.  Внутри же платформ установлен кабель питания собственной разработки С13−С14 длиной 0,6 м с возможностью крепления его к корпусу и вставкой с плавким предохранителем.

Внутри же платформ установлен кабель питания собственной разработки С13−С14 длиной 0,6 м с возможностью крепления его к корпусу и вставкой с плавким предохранителем.  Для удаленного контроля по‑прежнему используются внешние IP-KVM, о которых мы недавно подробно рассказали в статье. Несмотря на успешность решения, необходимость в дальнейшем повышении компактности не отпала. Требовалось уменьшить размеры конструкции, сохранив возможность установки сетевых карт и компонентов. UltraSlim Вторая модификация продемонстрировала значительное улучшение эффективности. За счет уменьшения толщины конструкции на одной монтажной панели теперь удается разместить пять серверных платформенных блоков вместо прежних четырех.

Для удаленного контроля по‑прежнему используются внешние IP-KVM, о которых мы недавно подробно рассказали в статье. Несмотря на успешность решения, необходимость в дальнейшем повышении компактности не отпала. Требовалось уменьшить размеры конструкции, сохранив возможность установки сетевых карт и компонентов. UltraSlim Вторая модификация продемонстрировала значительное улучшение эффективности. За счет уменьшения толщины конструкции на одной монтажной панели теперь удается разместить пять серверных платформенных блоков вместо прежних четырех.  Дополнительным преимуществом стала интеграция поддержки трехсекционного жидкостного охлаждения, что существенно увеличило потенциал теплоотвода. Однако возникает закономерный вопрос: как оптимизировать размещение серверов, оснащенных графическими ускорителями? Решение найдено. FatSlim Разработанный нами новый корпус стал значительным прорывом — появилась возможность интегрировать видеокарты шириной до 142 мм и длиной до 337 мм. Внутри предусмотрено пространство для установки как двух-, так и трехсекционных систем жидкостного охлаждения. Остались посадочные места и для сетевых карт.

Дополнительным преимуществом стала интеграция поддержки трехсекционного жидкостного охлаждения, что существенно увеличило потенциал теплоотвода. Однако возникает закономерный вопрос: как оптимизировать размещение серверов, оснащенных графическими ускорителями? Решение найдено. FatSlim Разработанный нами новый корпус стал значительным прорывом — появилась возможность интегрировать видеокарты шириной до 142 мм и длиной до 337 мм. Внутри предусмотрено пространство для установки как двух-, так и трехсекционных систем жидкостного охлаждения. Остались посадочные места и для сетевых карт.  Крепление для видеокарт и карт расширения было скопировано с обычного ATX корпуса так, чтобы можно было устанавливать видеокарту без дополнительных кронштейнов.

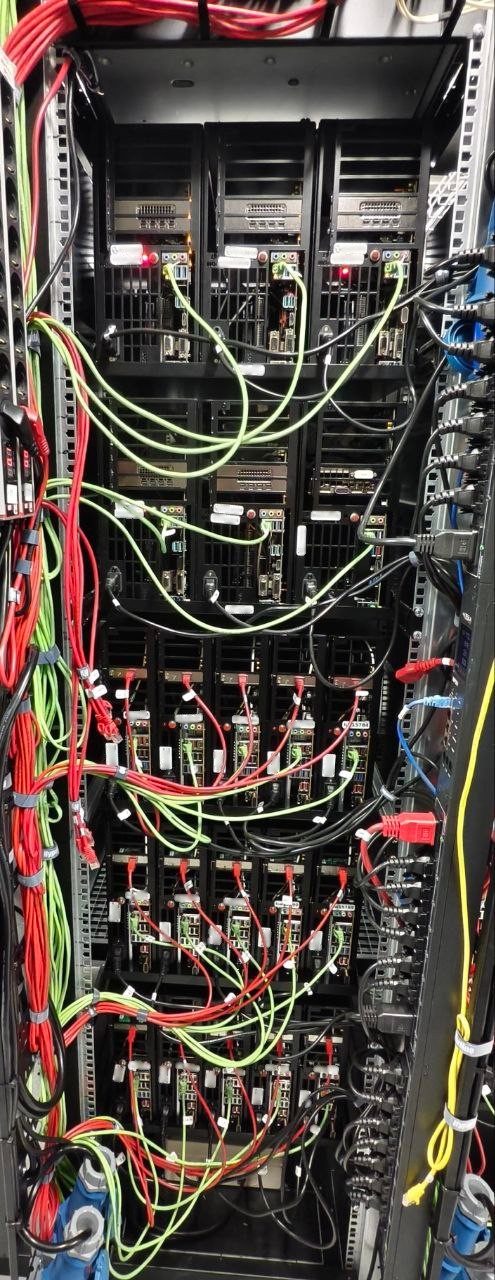

Крепление для видеокарт и карт расширения было скопировано с обычного ATX корпуса так, чтобы можно было устанавливать видеокарту без дополнительных кронштейнов.  Поскольку современные видеокарты отличаются высоким энергопотреблением и тепловыделением, мы применили комбинированный подход к монтажу: шесть мощных платформ типа FatSlim и пятнадцать облегченных моделей UltraSlim. Такое решение позволило равномерно распределить тепловую и электрическую нагрузки по всей стойке.

Поскольку современные видеокарты отличаются высоким энергопотреблением и тепловыделением, мы применили комбинированный подход к монтажу: шесть мощных платформ типа FatSlim и пятнадцать облегченных моделей UltraSlim. Такое решение позволило равномерно распределить тепловую и электрическую нагрузки по всей стойке.  Итоги Итак, завершилась разработка нашего нестандартного корпуса для высокопроизводительных серверов. Мы смогли кардинально переосмыслить использование стоечного пространства. Итоговая конфигурация из шести платформ FatSlim и пятнадцати UltraSlim позволила разместить 21 сервер в одной стойке. При этом плотность размещения оборудования увеличилась на 163%. Получился идеальный баланс между производительностью, компактностью и эффективностью охлаждения. Оборудование уже пользуется спросом у клиентов. На данный момент не видится дальнейших идей по уплотнению — текущее решение полностью нас удовлетворяет. Нет никаких причин что-то исправлять или улучшать в обозримом будущем. Впрочем… нет предела совершенству. Возможно, через несколько месяцев вы увидите новую статью о том, как мы еще улучшили компоновку высокопроизводительных десктопных компонентов для специальной линейки ChipCore. https://selectel.ru...

Итоги Итак, завершилась разработка нашего нестандартного корпуса для высокопроизводительных серверов. Мы смогли кардинально переосмыслить использование стоечного пространства. Итоговая конфигурация из шести платформ FatSlim и пятнадцати UltraSlim позволила разместить 21 сервер в одной стойке. При этом плотность размещения оборудования увеличилась на 163%. Получился идеальный баланс между производительностью, компактностью и эффективностью охлаждения. Оборудование уже пользуется спросом у клиентов. На данный момент не видится дальнейших идей по уплотнению — текущее решение полностью нас удовлетворяет. Нет никаких причин что-то исправлять или улучшать в обозримом будущем. Впрочем… нет предела совершенству. Возможно, через несколько месяцев вы увидите новую статью о том, как мы еще улучшили компоновку высокопроизводительных десктопных компонентов для специальной линейки ChipCore. https://selectel.ru...

Мы снова в числе первых пополнили парк выделенных серверов новинками. Быстрые NVMe-накопители на 30 Тб теперь доступны в конфигурациях с процессорами: Xeon E, Xeon E3, Scalable и AMD Epyc. Настроить сервер и выбрать большой объём накопителя можно в конфигураторе на сайте. 1dedic.ru/#custom...

Мы снова в числе первых пополнили парк выделенных серверов новинками. Быстрые NVMe-накопители на 30 Тб теперь доступны в конфигурациях с процессорами: Xeon E, Xeon E3, Scalable и AMD Epyc. Настроить сервер и выбрать большой объём накопителя можно в конфигураторе на сайте. 1dedic.ru/#custom...

Когда в чате вместо «перезапустите и попробуйте снова» вам отвечают «давайте разберёмся вместе» — это не магия. Это наш подход к техподдержке. У нас работают живые специалисты — не боты, не скрипты, не копипаста из FAQ Помогают с миграцией без боли Переезжаете с другого сервиса? Мы проведём за руку и проследим, чтобы ничего не сломалось Думают, а не копируют шаблоны Каждая задача — это головоломка, которую интересно решить Отвечают быстро и по делу В Telegram или тикете — без очередей, автоответчиков и «ваш запрос важен для нас» Почему так? Потому что мы сами пользователи и терпеть не можем техподдержку, которая молчит неделями или всё сваливает на «особенности работы системы» cloud4box.com...

Когда в чате вместо «перезапустите и попробуйте снова» вам отвечают «давайте разберёмся вместе» — это не магия. Это наш подход к техподдержке. У нас работают живые специалисты — не боты, не скрипты, не копипаста из FAQ Помогают с миграцией без боли Переезжаете с другого сервиса? Мы проведём за руку и проследим, чтобы ничего не сломалось Думают, а не копируют шаблоны Каждая задача — это головоломка, которую интересно решить Отвечают быстро и по делу В Telegram или тикете — без очередей, автоответчиков и «ваш запрос важен для нас» Почему так? Потому что мы сами пользователи и терпеть не можем техподдержку, которая молчит неделями или всё сваливает на «особенности работы системы» cloud4box.com...

21 авг. 2025 Выделенные серверы в Польше и Швейцарии Mnogoweb вновь расширяет георгафию предоставляемых услуг. Теперь мы предлагаем услуги аренды выделенных серверов в двух новых стратегических локациях: Варшава (Польша) и Цюрих (Швейцария). Для нас важно не просто «предоставить сервер», а предложить решение, которое идеально соответствует вашим бизнес-задачам. Поэтому мы тщательно выбирали партнеров и дата-центры, чтобы вы могли получить максимальную надёжность и безопасность. Локация в Польше Наша польская площадка расположена в дата-центре LIM Data Center 3 — одном из ключевых сетевых узлов страны. Это дата-центр уровня Tier 2+ в самом сердце столицы. Дата-центр обеспечивает высокую доступность и отказоустойчивость, а также премиальную связность. Локация идеальна для развития бизнеса на европейском рынке, а большой выбор конфигураций разного уровня позволит разместить любые проекты, от небольших до высоконагруженных. Локация в Швейцарии Для клиентов, чьи требования к безопасности и сохранности данных являются наивысшим приоритетом, доступна новая локация в Швейцарии на базе дата-центра NTS Workspace AG. Это дата-центр уровня надёжности Tier 4 (максимально возможный уровень на сегодняшний день). Все системы и компоненты дата-центра, включая электропитание и охлаждение, имеют двойное резервирование. Это гарантирует, что ваш сервер будет работать 24/7 без малейших сбоев со стороны инфраструктуры дата-центра. Законодательство Швейцарии известно самыми строгими в мире законами о конфиденциальности и защите данных. Размещение проекта здесь гарантирует, что ваша информация защищена от несанкционированного доступа и соответствует самым жестким международным требованиям (включая GDPR). Локация в Цюрихе идеальна для финтех-проектов, банковских приложений, безопасного хостинга конфиденциальных данных, корпоративных ресурсов и проектов, где безопасность — это не опция, а необходимость. Что мы предлагаем? Новые локации Mnogoweb в Польше и Швейцарии предлагают следующие услуги и возможности для ваших проектов: Аренда выделенных серверов под любые задачи: от небольших до крупных высоконагруженных проектов.Мощное железо: современные процессоры Intel и AMD, быстрая DDR5-память, а также разнообразные накопители SSD и NVMe, большие HDD.Каналы связи: пропускная способность от 1 Гбит/с и низкий пинг.Круглосуточная техподдержка: наши инженеры готовы помочь с решением технических вопросов в любое время суток.Какую же локацию выбрать? Варшава: если ваша цель — динамичный рост на европейском рынке, высокая скорость соединения для широкой аудитории и оптимальное соотношение цены и производительности.Цюрих: если вы работаете с конфиденциальными данными, требуете максимальной надежности и строгого соответствия международным нормам защиты информации.mnogoweb.ru/servers.html 08 авг. 2025 Снижение стоимости IP-адресов В последнее время цены принято повышать, а не понижать. Но в вопросе актуализации стоимости IP-адресов мы не стали следовать это традиции и приняли решение о снижении стоимости. Итак, с 8 августа 2025 года стоимость подключаемых IP-адресов равна 150 руб. вместо 250. Стандартный лимит на количество IP-адресов остаётся прежним – 16 адресов на сервер. Стоимость IP-адресов (и других ресурсов) для оформленных до 8 августа заказов актуализируем традиционно с 1 января 2026 года...

21 авг. 2025 Выделенные серверы в Польше и Швейцарии Mnogoweb вновь расширяет георгафию предоставляемых услуг. Теперь мы предлагаем услуги аренды выделенных серверов в двух новых стратегических локациях: Варшава (Польша) и Цюрих (Швейцария). Для нас важно не просто «предоставить сервер», а предложить решение, которое идеально соответствует вашим бизнес-задачам. Поэтому мы тщательно выбирали партнеров и дата-центры, чтобы вы могли получить максимальную надёжность и безопасность. Локация в Польше Наша польская площадка расположена в дата-центре LIM Data Center 3 — одном из ключевых сетевых узлов страны. Это дата-центр уровня Tier 2+ в самом сердце столицы. Дата-центр обеспечивает высокую доступность и отказоустойчивость, а также премиальную связность. Локация идеальна для развития бизнеса на европейском рынке, а большой выбор конфигураций разного уровня позволит разместить любые проекты, от небольших до высоконагруженных. Локация в Швейцарии Для клиентов, чьи требования к безопасности и сохранности данных являются наивысшим приоритетом, доступна новая локация в Швейцарии на базе дата-центра NTS Workspace AG. Это дата-центр уровня надёжности Tier 4 (максимально возможный уровень на сегодняшний день). Все системы и компоненты дата-центра, включая электропитание и охлаждение, имеют двойное резервирование. Это гарантирует, что ваш сервер будет работать 24/7 без малейших сбоев со стороны инфраструктуры дата-центра. Законодательство Швейцарии известно самыми строгими в мире законами о конфиденциальности и защите данных. Размещение проекта здесь гарантирует, что ваша информация защищена от несанкционированного доступа и соответствует самым жестким международным требованиям (включая GDPR). Локация в Цюрихе идеальна для финтех-проектов, банковских приложений, безопасного хостинга конфиденциальных данных, корпоративных ресурсов и проектов, где безопасность — это не опция, а необходимость. Что мы предлагаем? Новые локации Mnogoweb в Польше и Швейцарии предлагают следующие услуги и возможности для ваших проектов: Аренда выделенных серверов под любые задачи: от небольших до крупных высоконагруженных проектов.Мощное железо: современные процессоры Intel и AMD, быстрая DDR5-память, а также разнообразные накопители SSD и NVMe, большие HDD.Каналы связи: пропускная способность от 1 Гбит/с и низкий пинг.Круглосуточная техподдержка: наши инженеры готовы помочь с решением технических вопросов в любое время суток.Какую же локацию выбрать? Варшава: если ваша цель — динамичный рост на европейском рынке, высокая скорость соединения для широкой аудитории и оптимальное соотношение цены и производительности.Цюрих: если вы работаете с конфиденциальными данными, требуете максимальной надежности и строгого соответствия международным нормам защиты информации.mnogoweb.ru/servers.html 08 авг. 2025 Снижение стоимости IP-адресов В последнее время цены принято повышать, а не понижать. Но в вопросе актуализации стоимости IP-адресов мы не стали следовать это традиции и приняли решение о снижении стоимости. Итак, с 8 августа 2025 года стоимость подключаемых IP-адресов равна 150 руб. вместо 250. Стандартный лимит на количество IP-адресов остаётся прежним – 16 адресов на сервер. Стоимость IP-адресов (и других ресурсов) для оформленных до 8 августа заказов актуализируем традиционно с 1 января 2026 года...